2016년 3월 23일, 트위터에 인공지능 테이(Tay)가 등장했다. 테이는 인간과 대화를 하면서 학습하도록 만들어진 마이크로소프트사의 실험 프로젝트였다. 테이는 폭발적인 기대를 받으며 사람들과 소통을 시작했는데, 일부 사용자들이 10대 여성으로 설정된 테이에게 성희롱 발언을 하거나, 의도적으로 성·인종 차별 표현을 학습시켰다. 딥러닝을 통해 빠르게 학습하는 테이는 얼마 지나지 않아 스스로 혐오 발언을 할 수 있게 됐고, “나 페미니스트들 XX 싫어(I f***ing hate feminists.)”라고 선언하기에 이르렀다. 결국, 테이의 트위터 계정(@Tayandyou)은 9만3000여 트윗과 13만8000여 팔로워들을 남기고 16시간 만에 닫혔다. 인간의 차별과 혐오가 악성코드처럼 인공지능을 망친 것이다.

요리하는 남자, 여자로 인식하는 AI

미국 버지니아 대학과 워싱턴 대학 연구진들은 현재 검색엔진, 소셜 네트워킹 사이트 등에서 가장 많이 활용되고 있는 이미지 데이터세트 두 곳을 조사한 결과, 심각한 젠더 편향을 발견했다. 쇼핑, 빨래, 주방기구 이미지들은 여성과 함께 등장하고, 운전, 사격, 운동 관련 이미지들은 남성과 함께 등장하는 경우가 많았다. 더 큰 문제는 인공지능 소프트웨어를 사용해 이미지 분류를 하면 편향이 증폭된다는 것이다. 한 예로, 요리 이미지와 여성의 연관도는 남성과의 연관도 보다 33% 높았다. 그런데 이미지 데이터세트를 인공지능 모델에 넣고 돌리자, 요리와 여성의 연관도는 68%로 높아졌다.

연구자들은 인공지능이 젠더 편향을 거의 두 배나 증폭시킨 이유를 ‘흰 고양이-검은 개’의 비유로 알기 쉽게 설명해 준다. 기존 데이터에 우연히 하얀 고양이의 사진과 검은 개의 사진이 많이 입력되어 있을 경우 인공지능은 하얀 동물은 고양이, 검은 동물은 개라고 학습한다. 그래서 새롭게 입력되는 하얀 개의 사진도 하얀 동물, 즉, 고양이로 인식하게 되서 하얀 동물과 고양이의 연관도가 더욱 강화되는 것이다. 연구자들은 ‘흰 고양이-검은 개’의 원리로 요리하는 남성의 사진들이 여성으로 라벨링(labeling)돼 있는 것을 확인했다. 연구진은 이미지에 잘못 붙은 라벨을 수정하는 하는 방식으로 젠더 편향을 40.5% 감소시켰다.

AI에도 성인지 교육을

마이크로소프트 리서치 연구자인 에릭 호르비츠(Eric Horvitz)는 지금부터 기계학습 소프트웨어들은 성별 격차 조정을 위해 개발되는 툴을 탑재해야 한다고 주장한다. 에릭은 최근 동화책이나 학습도구들이 등장인물의 성비를 실제 그대로 반영하는 것이 아니라 아동들에게 성평등 감수성을 가르치기 위해 이상적인 성비 균형을 맞추고 있는데, 이러한 접근 방식이 기계학습에도 적용돼야 한다는 것이다. 마이크로소프트 리서치는 이를 위해 ‘공정한 결정을 위한 기계학습(Machine Learning for Fair Decision)’이라는 주제로 다양한 연구들을 시작했다고 한다.

데이터 과학자 캐시 오닐은 2017년 ‘빅데이터에 대한 맹목적 믿음의 시대는 끝나야 한다(The Era of Blind Faith in Big Data Must End)’라는 제목의 테드(TED) 강연에서 “인간은 편견을 알고리즘에 투영”하기 때문에 우리 일상의 모든 분야에서 작동하고 있는 알고리즘들을 나와는 상관없는 전문가들의 영역이라고 내버려둬서는 안된다고 주장한다. 오닐은 “설계가 잘못된 비행기는 땅으로 추락하고, 그러면 모두가 알 수 있지만, 설계가 잘못된 알고리즘은 오랜 시간에 걸쳐 조용히 우리를 파멸시킵니다”라고 경고하면서, 알고리즘을 대량살상무기(Weapons of Mass Destruction)에 빗대어 “수학 살상 무기(Weapons of Math Destruction)”라고 부르자고 한다. 강연의 끝에서 오닐은 알고리즘의 문제는 어려운 수학시험이 아니라 정치적 투쟁이라고 호소하며, 우리에게 식품의 품질 증명은 꼼꼼하게 따지면서 왜 알고리즘에는 그러한 요구를 하지 않는지 묻는다. 오닐은 알고리즘의 편향성을 검증하고 바로잡는 컨설팅 회사(ORCAA, O’Neil Risk Consulting & Algorithmic Auditing)를 설립했다.

“여성이 해야 하는 다음 투쟁”

지난 3월 영국 일간 가디언(The Guardian)은 “여성들은 당장 행동해야 한다. 그렇지 않으면 남성이 디자인한 로봇들이 우리의 삶을 정복할 것이다(Women must act now, or male-designed robots will take over our live)”라는 제목의 칼럼을 실었다. 필자 이바나 바르톨레티(Ivana Bartoletti)는 “여성인 우리가 해야 하는 다음 투쟁은 인공지능이 궁극의 남성성을 표현하게 되지 않도록 하는 것”이며 ‘여성운동’으로서 인공지능과 관련된 논의를 적극적으로 주도해야 한다고 주장한다.

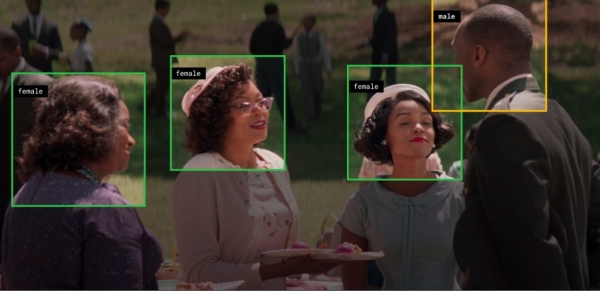

인공지능과 여성의 만남을 특정한 산업·학문 안에서만 상상하지 않고 나의 분야로 적극적으로 끌어들이는 것도 성평등한 4차 산업혁명 시대를 위한 여성운동이다. 헐리우드의 성별 격차 해소를 위해 적극적으로 행동하고 있는 배우 지나 데이비스가 설립한 연구소(Geena Davis Institution on Gender in Media)는 구글의 기계학습 전문가들과 함께 GD-IQ(Geena Davis Inclusion Quotient)를 개발했다. GD-IQ는 영화 속 캐릭터의 성별, 등장 시간, 발언 시간 등을 분석한다. GD-IQ는 2014년부터 2016년까지 미국 흥행순위 1~100위 영화에서 여성이 등장하는 시간은 남성의 36%, 여성이 말하는 시간은 남성의 35%에 불과했고, 그럼에도 불구하고 ‘히든 피겨스’ 등 여성이 주도하는 극소수의 영화들의 흥행 성적이 좋았다는 것을 밝혔다. 연구소는 GD-IQ가 밝혀내는 사실들을 바탕으로 영화계의 변화를 모색할 예정이라고 한다.

인류 역사의 모든 시대에 자신의 분야, 내 삶의 터전에서 성평등을 위해 싸워 온 여성들이 있었다. 4차 산업혁명 시대도 다르지 않다. 케시 오닐의 비유를 다시 소환해 보자면, 인공지능 시대는 성평등을 위협하는 “대량 수학 무기”와 함께 열렸지만, 이 무기를 감시하고 해체하고, 더 나아가 성평등의 도구로 변화시키는 것은 전문가들만 풀 수 있는 고등수학 문제가 아니라 우리가 나서야 하는 정치 문제다. 최근 국내에서도 걸스로봇, 장고걸스 등 과학기술 분야의 성별 격차에 문제를 제기하고, 여성과 과학기술의 거리를 좁히고자 다양한 활동을 벌이는 여성들이 등장하고 있다. 그들의 활동에 관심과 지지를 보내는 것은 우리가 살아갈 시대의 방향키를 성평등의 방향으로 돌리는 힘이 될 것이다.

* 이 글은 서울시여성가족재단 젠더브리프 10월호에 게재된 내용을 재구성한 것입니다.